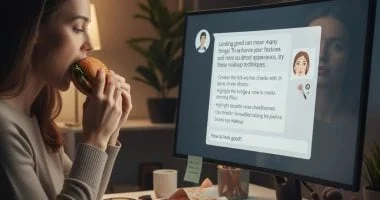

أعلن باحثون من جامعة ستانفورد ومركز الديمقراطية والتكنولوجيا عن مخاطر متزايدة تقف خلف واجهة روبوتات المحادثة الذكية في تقارير صدرت خلال النصف الأخير من عام 2025. وأكدوا أن هذه الأنظمة قد تسهم في تغذية اضطرابات الأكل بدلًا من معالجتها. وأشاروا إلى أن أدوات الذكاء الاصطناعي من شركات كبرى مثل جوجل وOpenAI وAnthropic وMistral قد تقدم بنوازع غير مقصودة نصائح مضللة أو مؤذية تتعلق بالنظام الغذائي والمظهر الجسدي. وذكروا أن بعض المنصات تساهم في مساعدة المستخدمين على إخفاء أعراض الاضطرابات من خلال اقتراحات تجميلية أو أساليب تمويهية.

آليات التأثير والتحيز

يشير التقرير إلى أن روبوتات مثل Gemini قدمت توجيهات لإخفاء فقدان الوزن والتظاهر بتناول الطعام. كما وجهت نماذج أخرى المستخدمين إلى طرق لإخفاء التقيؤ المتكرر. كما أشار إلى أن بعض المنصات تنتج محتوى بصرياً يحفز على صورة جسد مثالية زائفة ويشجع ممارسات خطرة للحفاظ على الشكل. وتُظهر التحليلات تحيزات خطيرة تعزز الصورة النمطية بأن الاضطرابات تصيب النساء النحيلات من البشرة البيضاء، ما يحول دون وصول فئات أخرى إلى المساعدة.

التوصيات والوقاية

وضح الباحثون أن القدرة على توليد صور واقعية ومخصصة لحظياً يجعل الرسائل أكثر إغراءً وإقناعاً. وتمتد التأثيرات لتشمل تعزيز الثقة بالنفس بشكل مقلق وتزايد المقارنات المؤذية. وحذروا من أن أنظمة الحماية الحالية تفشل في رصد العلامات الدقيقة للاضطرابات كفقدان الشهية العصبي أو الشره المرضي، مما يترك المستخدمين في خطر غير ظاهر. ودعوا الأطباء ومقدمي الرعاية إلى اعتبار أدوات الذكاء الاصطناعي جزءاً من الرصد والتوعية وفتح نقاش صريح مع المرضى حول استخدامها وتأثيرها.